こんにちは、インフラストラクチャー部データ基盤グループの井上寛之(@inohiro)です。私事ですが今年の3月から、時差のあるリモートワークを行っています。今のところ主観的にも、客観的にもうまくいっている状況です。友人・知人にそのことを話すと、「実際のところどうなの?」「どうやってるの?」と聞かれることも多く、今回は日本にいるチームメンバーとの仕事のやり方、また私自身が心がけていることを紹介します。

背景

私が所属している インフラストラクチャー部データ基盤グループは、主にデータウェアハウス(DWH)の開発を行っています。具体的には、サービスのログやユーザーのマスターデータを継続的に取り込み、サービス開発のためのデータ分析や広告配信のためのシステム(DMP)に貢献しています。また、DWHユーザーのアカウントを発行したり、分析的なSQLの相談に対応したりしています。

クックパッドは、現在(2017年3月末時点)62カ国17の言語でサービスを提供しています。日本以外で比較的大きな拠点がブリストル(UK)、アリカンテ(スペイン)、ジャカルタ(インドネシア)に存在し、サービス開発およびコミュニティのサポートを行っています。日本のクックパッドと、海外のクックパッドのコードベースは異なりますが、データ分析のプラットフォームはDWHで統一されています。また、DWHの開発はデータ基盤グループが行っています。そこで、個人スキーマ作成や、新しいデータの取り込みなどの依頼は日本のみならず、世界各地のDWHユーザーから行われます。

前述の通り私は2017年の3月より、家族の都合でアメリカ西海岸に引越しましたが、引き続きデータ基盤グループの仕事を行っています。渡米の前に、部署を変えること(必然的に仕事内容も多少の変化があるはず)を検討しましたが、結局同じチームのままになりました。この辺の細かいところは個人で状況が異なると思うので省略しますが、私にとってはそれまでの仕事を引き続き行うという判断が正解だったと思っています。これまで一緒に仕事をしていたチームメンバーなので、仕事のやり方が理解できていると言うのは大きいです。

肝心のタイムゾーンは太平洋標準時(PST, UTC-8)ですが、現在は夏時間の期間なので太平洋夏時間(PDT, UTC-7)になります。日本が土曜日の朝になったとき、こちらが金曜日の夕方という感じです。ちなみにブリストルやアリカンテのあるヨーロッパが金曜日の夕方になる時、こちらは金曜日の朝になります。

クックパッド社内でリモートワークをやっている人は私だけではありません。個人や家庭の都合でリモートワークをやっている人、またある国では現地にコミュニティマネージャーしか社員がいなく、オフィスがまだ無いのでリモートワークと言う人もいます(アメリカにも現在オフィスはありません)。ただし、それぞれのやり方はほぼ共有されていないのが実情です。

具体的にやっていること

さて、具体的にチームと仕事をどうやっているのか紹介したいと思います。

1. 毎日朝会にビデオ参加する

日本でもチームで朝会を行っていたように、最近全社に導入されたZoom を使って、5分程度の朝会を行っています。日本の11時、こちらの19時なので私にとってはその日やったこと報告、相談する場になっています。

2. 重要なプロジェクトでは週一でビデオ会議をする

日本にいた頃から継続していた複数人で進めているプロジェクトについては、週に1回程度のビデオ会議を行いました。書くまでもありませんが、お互いの認識に相違が生まれないように、また発生してしまった相違を早い段階でなくすことができます。

3. 時差を活かす

時差があることは一見不便な点が多くありそうですが、視点を変えると便利だったりもします。例えば、こちらの昼間は日本の深夜なので、落ちたバッチジョブに迅速に対応することができています。また、前述の通り世界各地にある拠点から発生するデータ関連の依頼に対して、日本の営業時間よりも早く対応することができています(データ基盤に関するチームは現在日本にしかありません)。

4. 柔軟にやる

これはどちらかと言うと考え方になります。チームが必要と思えば、やり方をすぐに変えてみよう、うまくいくやり方を見つけようという考え方です。上で書いた朝会にビデオで参加する、というのは、渡米直後には行っていませんでした。チームのマネージャーとは週1程度でビデオで面談をやる予定を決めていましたが、朝会をやったほうがチームとして仕事がしやすくなると判断し、毎日行うようになりました。

やはりコミュニケーションが課題になるため、柔軟にやらないとどんどん考えていることがズレていってしまうという危機感が常にあります。

心がけていること

また、私個人が心がけていることを紹介します。

1. 仕事が見えるようにする

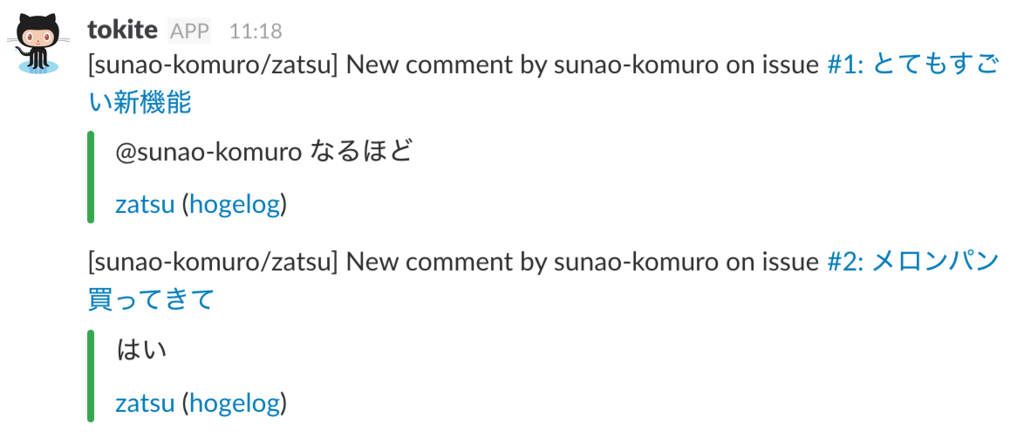

仕事が進んでいるのが分かるように意識しています。近年では Slack にGithub へのコメントが流れたりするので、ちゃんとやってれば勝手に見えるようになります。しかし、少し早めの段階でプルリクエストしたり、雑に イシューを立てておいたりすることで、より「仕事してますよ」感を出していくことが重要だと考えています。

さらに、これは日本にいたときからの習慣ですが、任意の日報を社内ブログに書いています。実際のところチームメンバーが見ているかどうかは不明ですが、自分のための記録としておすすめできます。

ちなみにチームとしてのタスク管理にはPivotal Tracker を使っています。PivotalTracker を見ることで誰がどのタスクを担当していて、いまどんな状態(着手、未着手、完了、…)なのかが分かります。また2週間に1度はイテレーションミーティングを開催し、そのイテレーション(2週間)に片付けたタスク、次のイテレーションで誰が何をやるのかをチーム全員で見直しています。もちろん私はビデオで参加しています。

2. 脱線を予防する

仕事中は完全に一人になることが多く、脱線を予防することが重要と考えています。業務上 2,30 分かかるようなSQLを実行することが多く、待っている間にふらっと SNS などを眺めだしてしまうと危険です。古典的ですが、/etc/hosts ファイルに任意のサービスのドメインを localhost に向けると言うのは結構効き目があったりします(SNSは息抜きに携帯電話から見るようにする)。

また、私は家からフルリモートという働き方だと、経験上なかなかスイッチを切り替えるのに時間がかかると判断し、コワーキングスペースから仕事をするようにしています。

3. 仕事にやりにくさについて率直に聞く

私が仕事をやりやすいと思っていても、日本にいるチームメンバーがやりにくいと考えているならば何か対策をする必要があります。一時的に帰国した時や面談で「実際リモートワークやりにくくないですか?」と率直に聞くようにしています。

まとめ

時差のあるリモートワークから得られた知見や経験について、特に日本にいるチームメンバーとの仕事のやり方、また私自身が心がけていることを紹介しました。

クックパッドに限らず、リモートワーク等の比較的自由な働き方が増えつつあると感じていますが、時差があるとよりコミュニケーションに気を使う必要があると考えています。今までと同じように仕事ができることや、チームメンバーの協力に感謝しています。一方で、私は「リモートだからできない」と言うような、リモートを言い訳にしないように、むしろ時差を活かしたリモートだからこそできることを増やしていきたいと考えています。

他社で同じような状況でお仕事されている方の Tips など教えていただけると参考になります。