コーポレートエンジニアリング担当 VP の @kani_b です。 昨今急速に拡大している新型コロナウイルス感染症の感染拡大リスクを鑑みて、従業員や関係者の皆さまの安全確保を目的に、クックパッドでは 2/18 (火) からまずは2週間ほど、国内拠点の全従業員(正社員、契約社員、パート・アルバイト、派遣社員、通常在席の業務委託)を対象に在宅勤務の原則化を実施することになりました。

クックパッド、新型コロナウイルスの拡大防止対策で、全従業員を対象に在宅勤務(Work from Home)を実施 | クックパッド株式会社

この記事では、現在クックパッドでどのような環境づくりのもと、在宅勤務が行われているかをご紹介します。

どの会社の方も同じような状況にあるかと思いますが、「他社ではどうやっているか」の一例として参考にしていただけると嬉しいです。

仕事に利用するシステム

クックパッドでは、業務にインターネットからアクセスできる各種クラウドサービスを多く利用しています。社内ツールもそのほとんどがインターネットからアクセスできるようになっています。 特に日常的に使われているのは以下のようなサービスです。

- オフィススイート: G Suite

- コミュニケーション: Slack, Zoom

- コラボレーション: GitHub.com, GitHub Enterprise

- Wiki, ドキュメンテーション: Groupad (内製ツール)

- ワークフロー: ServiceNow

- 人事・会計: Workday

日常業務の多くのシーンでこれらのシステムを活用しています。また、ここに挙げたツールは、雇用形態や勤務時間・国によらず原則ほぼすべての従業員が利用可能になっています。また業務の多くをこれらを活用する形で設計しているため、例えば特定部署でほとんど利用されていない、といった事象が起きにくくなっています。

環境の調査

在宅勤務の原則化を行うにあたり、オフィスとなる全従業員の自宅について、どういった環境があるかがわからなければ方針を決めることも難しいです。そのため全従業員を対象としたアンケートを Google Forms を使って行いました。具体的には以下のような項目をヒアリングしました。

- 自宅に安定して接続できるインターネット環境はあるか

- 遠隔会議のために利用しているマイクはあるか

- その他、会社からの支援が必要な項目

在宅勤務開始にあたり、「あれもこれもサポートしなければ!」と先に考えてしまうと、実は需要のなかったことに時間を使ってしまうことになりかねません。準備を進めつつ、従業員の状況を把握しておくことが、より効果的な対応のためには重要です。

PC の持ち出し

クックパッドではもともと、個人に割り当てられた PC の持ち出しをほとんどの場合において許可しています 。持ち出しにあたっては、パスワードの設定などはもちろんのこと、内蔵記憶領域の暗号化など必要な設定が必ず行われるようになっています。 MDM (Mobile Device Management) として Microsoft Intune や Jamf Pro を利用し、管理を行っています。

PC 上のイベントは EDR (Endpoint Detection and Response) 製品を利用して監視やイベント対応を行っています。現在は主に CrowdStrike Falcon を利用しています。 また、特に機微な情報に触れるようなケースでは、VDI (仮想デスクトップ環境) として Amazon WorkSpaces を利用し、クライアント PC から接続して利用するようにしています。

備品の持ち出し

日頃から希望者にはマウスやキーボード、プライバシーフィルターなどの備品を (可能な限り希望に沿うものを) 貸し出しており、それらの社外持ち出しに特に制限はありませんでした。 備品の中でも特に大きいものとして、PC 用ディスプレイがあります。個人差はありますが、ディスプレイの有無によって作業効率が大きく変わることがあります。 今回は、「オフィスが主、自宅が副」の状態から、「自宅が主」に変わるということもあり、ディスプレイの持ち出しについても許可することにしました。

在宅勤務の原則化が決定されたのち、全従業員対象のアンケートで「ディスプレイの持ち出しを希望するか」を集計し、数を見積もりました。その後、破損防止のための梱包材を急遽用意し、各自で自宅にディスプレイを送付できるようにしました。

インターネット環境

スマートフォンでできることが増え、通信速度も年々向上している昨今、自宅にいわゆる固定のインターネット環境を持たない方もいます。最初に行った環境調査により人数の見積もりができたため、そういった方には会社からモバイルルーターの貸し出しを行いました。モバイルルーターの在庫も大量には持ち合わせていないため、テザリングの利用を前提に、会社で貸与できる携帯電話も活用しています。

現在のところ、モバイルルーターを利用している従業員の多くは問題なく業務できているようですが、高解像度の画像や動画を扱う業務が多いと厳しいという声も聞こえており、契約データ量については注意が必要です。クックパッドでも対応を検討しています。

VPN の利用

クックパッドでは以前より、社内ネットワークなどいわゆる境界を用いたセキュリティ対策の排除を進めていました。*1

ほぼすべての社内システムは Azure AD, もしくは G Suite アカウントを用いた SSO 環境下にあり、 HTTPS を必須化するなどインターネットから直接アクセスされることを前提に社内システムを構築しています。またほぼすべての認証 (エンジニアが利用する SSH なども含む) では 2FA が必須化されています。

現状では、利用するソフトウェアの制約により Google Drive などに移行されていないファイルサーバ、開発時に利用するデータベースなど、主に Web ではないトラフィックについて VPN を必要とする箇所が若干残っています。今回の在宅勤務の原則化に伴い、既存の VPN 環境のキャパシティ不足が懸念されたため、一次対応としてエンジニアには sshuttle を利用した VPN への切り替えをアナウンスしました。上記のような取り組みにより、キャパシティ不足に陥ることなく問題なく稼働しています。

遠隔会議

クックパッドでは遠隔会議のためのツールとして Zoomのライセンスを全従業員に発行し、利用しています。日常的に Zoom を使ったミーティングを行う従業員は多いため、利用そのものに大きな問題はありませんでした。 しかし、遠隔会議ではマイクを含めた音声品質が非常に重要です。オフィスではほぼすべての会議室に Zoom Rooms と専用ハードウェアを導入しているため、非常に快適な音声環境が得られますが、自宅ではそううまくいきません。

PC 内蔵のマイクでは、キータイプ音が混じったり音をうまく拾わなかったりなど、長時間の会議には不向きなことがわかっていました。特に、イヤホン・ヘッドホンなど声を聴くためのデバイスは分離しておいたほうが良いようです。 そのため、外付けマイクやヘッドホンをお持ちでない方には以下のような対応を推奨しています。

- iPhone やスマートフォンに付属する純正のイヤホンマイクの利用

- ミニピンジャックのものは Windows や MacBook でも動作する

- スマートフォンやタブレットからの参加

- PC は別途参加させ、画面共有などに利用する

Zoom ではバーチャル背景機能がよく使われています。これは、部屋の中などを映したくない際に背景を任意の画像に合成してくれる機能です。最近は動画を使えるようになっており、ミーティング開始時のウケを狙いたい人などによく使われています。

また、Zoom による会議がデフォルトになったことによって、会議のためのツールもスライドではなく Google Docs によるドキュメント共有が使われるなど、変化が起きています。これにより非同期に質問を書き込めるようになったり、Google Slides にふせんのようなテンプレートを用意したりするなど、会議の実施方法が進化しておりそれが便利、という声もありました。

社外の方への参加依頼

これまでオフィスで行っていたお客様との打ち合わせや、採用面接についても、Zoom を使った形への切り替えをお願いしています。 今回の目的を達成するためには、従業員だけでなく社外のお客様にご協力いただくことが必要不可欠です。特に遠隔会議においては、環境のセットアップなどでご負担をお願いすることも多いため、お客様向けの簡単なご案内を作成しお送りする試みをはじめています。

ログ収集と運用

在宅勤務を可能にする上で、ほとんどの会社がまず気にかけるのはシステムのセキュリティでしょう。クックパッドでは、これまで紹介したセキュリティに関する仕組みの多くについて、そのログ収集と監視をセキュリティ設計の上での重要事項としています。

現在、ログはすべてセキュリティログ検索基盤に集約され、疑わしいイベントなどが発生した場合に調査できるようになっています。詳しい実装については以下の記事をご覧ください。 Amazon Athena を使ったセキュリティログ検索基盤の構築 - クックパッド開発者ブログ

で、実際どう?

現在の体制となって4日が経過しました。現在のところ、ほぼ全員が在宅勤務をしています。 コーポレートエンジニアリング部では、システム利用で困った際のヘルプデスク(サービスデスク)も担当していますが、この業務のほとんどもリモート環境で行われています。

今回の措置が発表された直後から、社内では #remote-work_ideas というチャンネルが Slack に作られ、椅子やマイクなどの情報交換のほかに、様々な試みが社内で行われています。私が見かけたものをいくつか紹介します。

入退室自由な雑談部屋

一人で黙々と作業をしていると、人に会うこともなく寂しさや不安を感じる方も多いようです。そうした人向けに Zoom ミーティングを作成し、誰でも入れるようにしています。オフィスでもなんとなく起きる程度の雑談を Zoom 内に再現する試みです。

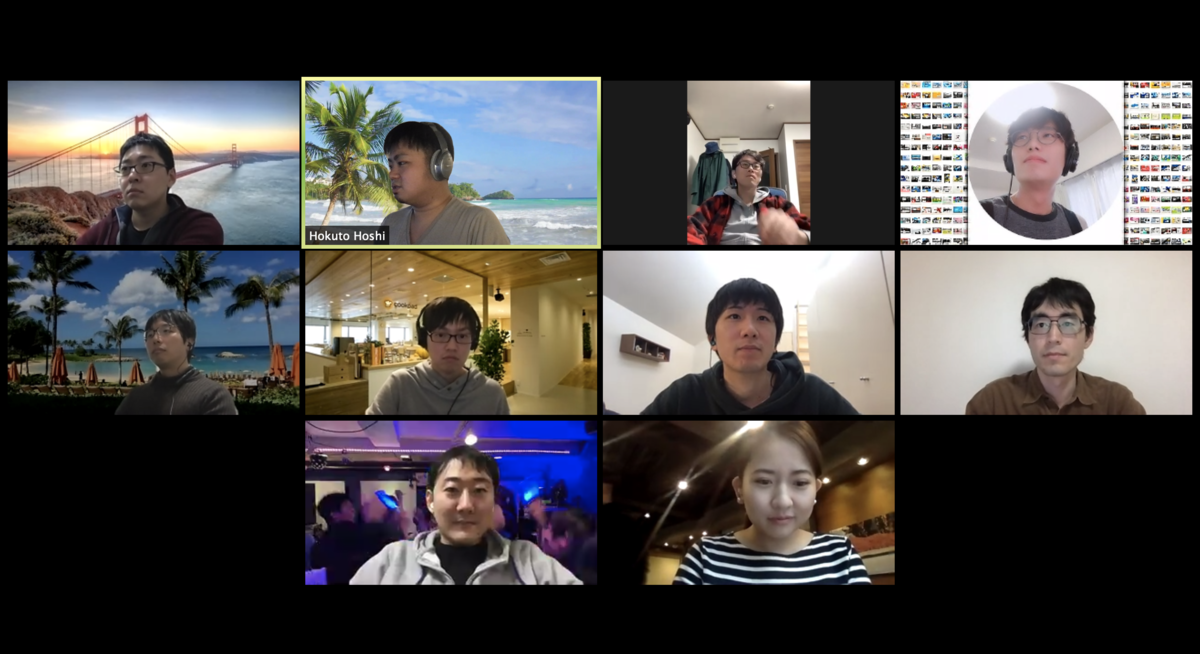

現在では色々な単位で部屋が存在し、部署内で実施されているものから部署関係なく「なんとなく」で人が集まっているものまで様々です。実際の様子はこんな感じ。

会社の受付にいそうな CTO をはじめ、南国やアメリカにいそうな人たちはバーチャル背景を利用しているだけで、自宅から接続しています。 参加者からは、「自宅だと全く人の目がないのでだらけがちだが、Zoom に接続しておくことで一定の緊張感が保てる点が好き」といった声もあがっています。

リモート昼ごはん

クックパッドのオフィスには大きなキッチンがあり、各自で料理をすることができるようになっています。が、お昼時はどうしても混み合いますし、打ち合わせなどで移動もあり、作れないことも…

原則在宅勤務となったことで、それぞれの自宅キッチンで料理する機会が図らずも生まれています。この機会を活かして、自宅でクックパッドを使って料理をする社員が増えています。Slack に #リモート昼ごはん というチャンネルが生まれ、今は Instagram や Twitter に投稿する社員もいるようです。 #クックパッド社員のお昼ごはん などで覗いてみてください。

ラジオ体操

在宅勤務では、打ち合わせなどで移動する必要のない反面、意識して体を動かさないといつのまにかつらい状態になっているという声がよく上がっています。 リングフィットアドベンチャーをやっている様子を配信している人や、チームで時間をとって Zoom で中継しながらラジオ体操をやる部署などが出てきているようです。

まだ4日ではありますが、各自・各チームが様々なアイデアをもって仕事を進めています。在宅勤務の実施にあたっては、生産性など様々な議論が行われていますが、我々も継続的な効果測定や改善を行っていきたいと考えています。 すでに実施している方、これから実施される方、検討中の方などにお役に立てば幸いです。

質問などありましたら @kani_b までお気軽に。

*1:昨今では、いわゆるゼロトラストネットワーク、BeyondCorp という形で浸透している概念に近いものです